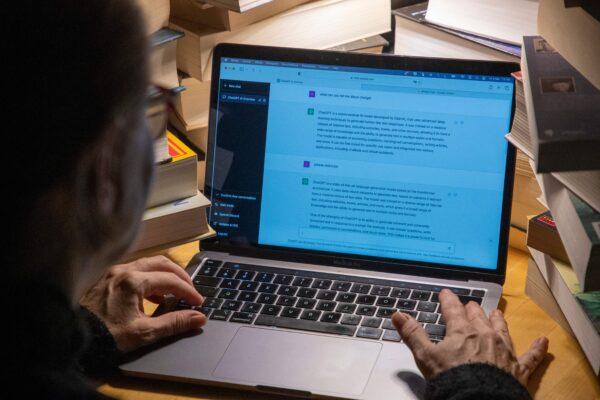

Quân đội Hoa Kỳ thành lập lực lượng đặc nhiệm trí tuệ nhân tạo tạo sinh

Hôn 10/08, Bộ Quốc phòng Hoa Kỳ cho biết, bộ đã thành lập một lực lượng đặc nhiệm để phân tích và tích hợp các công cụ trí tuệ nhân tạo (AI) tạo sinh, chẳng hạn như các mô hình ngôn ngữ lớn, trong toàn cơ quan.

Theo bộ, Lực lượng Đặc nhiệm Lima “sẽ đánh giá, đồng bộ, và sử dụng các khả năng AI tạo sinh” trên toàn Bộ Quốc phòng, bảo đảm Hoa Kỳ luôn dẫn đầu trong công nghệ tân tiến này trong khi bảo vệ an ninh quốc gia.

Lực lượng đặc nhiệm này được thành lập dưới sự chỉ thị của bà Kathleen Hicks, thứ trưởng Bộ Quốc phòng, và sẽ do ông Craig Martell, giám đốc kỹ thuật số và trí tuệ nhân tạo của bộ, lãnh đạo.

Ông Martell cho biết Hoa Kỳ sẽ cần “xác định các biện pháp bảo vệ thích hợp và giảm thiểu rủi ro an ninh quốc gia có thể xảy ra do các vấn đề như dữ liệu đào tạo được quản lý kém” khi áp dụng AI tạo sinh.

Ông Martell cho biết trong một thông cáo báo chí: “Chúng ta cũng phải xem xét mức độ mà các đối thủ của chúng ta sẽ sử dụng công nghệ này và tìm cách phá vỡ việc sử dụng các giải pháp dựa trên AI của chính chúng ta.”

Theo Diễn đàn Kinh tế Thế giới, AI tạo sinh đề cập đến các thuật toán AI tạo ra nội dung mới “dựa trên dữ liệu mà các thuật toán này đã được đào tạo.” Quân đội Hoa Kỳ đặt mục tiêu sử dụng công nghệ này để tăng cường khả năng chiến đấu, công việc kinh doanh, sức khỏe, sự sẵn sàng, và chính sách của mình.

Tháng trước (07/2023), Đại tá Không quân Hoa Kỳ Matthew Strohmeyer nói với Bloomberg rằng quân đội Hoa Kỳ đã tiến hành đánh giá trực tiếp các mô hình AI tạo sinh để xác định khả năng tồn tại công cụ này trong quá trình ra quyết định.

Đại tá Strohmeyer nói rằng các công cụ AI có thể xử lý “dữ liệu mật và cấp độ bí mật” trong vòng 10 phút, giảm đáng kể so với số giờ hoặc ngày mà con người thường cần có để hoàn thành một nhiệm vụ như vậy.

“Điều đó không có nghĩa là việc này đã sẵn sàng cho khung giờ vàng ngay bây giờ,” ông nói với hãng thông tấnn. “Nhưng chúng tôi chỉ làm điều đó trực tiếp. Chúng tôi đã làm điều đó với dữ liệu cấp độ bí mật.”

Tuyên bố về việc sử dụng trí tuệ nhân tạo có trách nhiệm trong quân đội

Đầu năm nay, Hoa Kỳ đã đưa ra một sáng kiến thúc đẩy hợp tác quốc tế về việc quân đội sử dụng trí tuệ nhân tạo và vũ khí tự động một cách có trách nhiệm, tìm cách áp dụng trật tự đối với một công nghệ mới nổi có khả năng thay đổi cách tiến hành chiến tranh.

Bà Bonnie Jenkins, Thứ trưởng Ngoại giao đặc trách Kiểm soát Vũ khí và An ninh Quốc tế, cho biết tuyên bố chính trị của Hoa Kỳ có các hướng dẫn phác thảo các phương pháp hay nhất để sử dụng AI có trách nhiệm trong quân đội.

Bà Jenkins nói rằng những tiến bộ trong công nghệ này “về căn bản sẽ làm thay đổi quân đội trên toàn thế giới,” thể hiện qua việc quân đội Ukraine áp dụng AI để phân tích các tình huống chiến trường.

“Đây là một công nghệ đang thay đổi nhanh chóng. Chúng ta có nghĩa vụ tạo ra các chuẩn mực mạnh mẽ về hành vi có trách nhiệm liên quan đến việc sử dụng AI trong quân đội, và theo cách lưu ý rằng các ứng dụng AI của quân đội chắc chắn sẽ thay đổi trong những năm tới,” bà nói hôm 16/02.

Tuyên bố của Hoa Kỳ có 12 điểm, một trong số đó nhấn mạnh sự cần thiết của việc “duy trì sự kiểm soát và tham gia của con người đối với tất cả các hành động quan trọng để thông báo và thực thi các quyết định có chủ quyền liên quan đến việc sử dụng vũ khí hạt nhân.”

AI quân sự làm tăng rủi ro chiến lược

Trung tâm An ninh Mỹ Mới (CNAS) đã cảnh báo trong một báo cáo (pdf) rằng việc sử dụng trí tuệ nhân tạo trong quân đội, kết hợp với căng thẳng đang diễn ra giữa Hoa Kỳ và Trung Quốc cộng sản, làm tăng nguy cơ xảy ra một thảm họa chiến lược.

Báo cáo nói rằng “sự cạnh tranh địa chính trị ngày càng gay gắt giữa Hoa Kỳ và [Trung Quốc]” đang kết hợp với “sự phát triển nhanh chóng của các công nghệ trí tuệ nhân tạo, trong đó có các ứng dụng quân sự.”

“Kết hợp lại với nhau, sự xuất hiện của AI quân sự có thể sẽ làm cho sự cạnh tranh giữa Hoa Kỳ và Trung Quốc nghiêm trọng hơn và gia tăng rủi ro chiến lược.”

Bản tin có sự đóng góp của Andrew Thornebrooke và The Associated Press

Minh Ngọc biên dịch

Quý vị tham khảo bản gốc từ The Epoch Times

Mới nhất

Mới nhất

Tiêu điểm

Tiêu điểm

Bình luận

Bình luận

Email

Email